جدیدترین مطالب

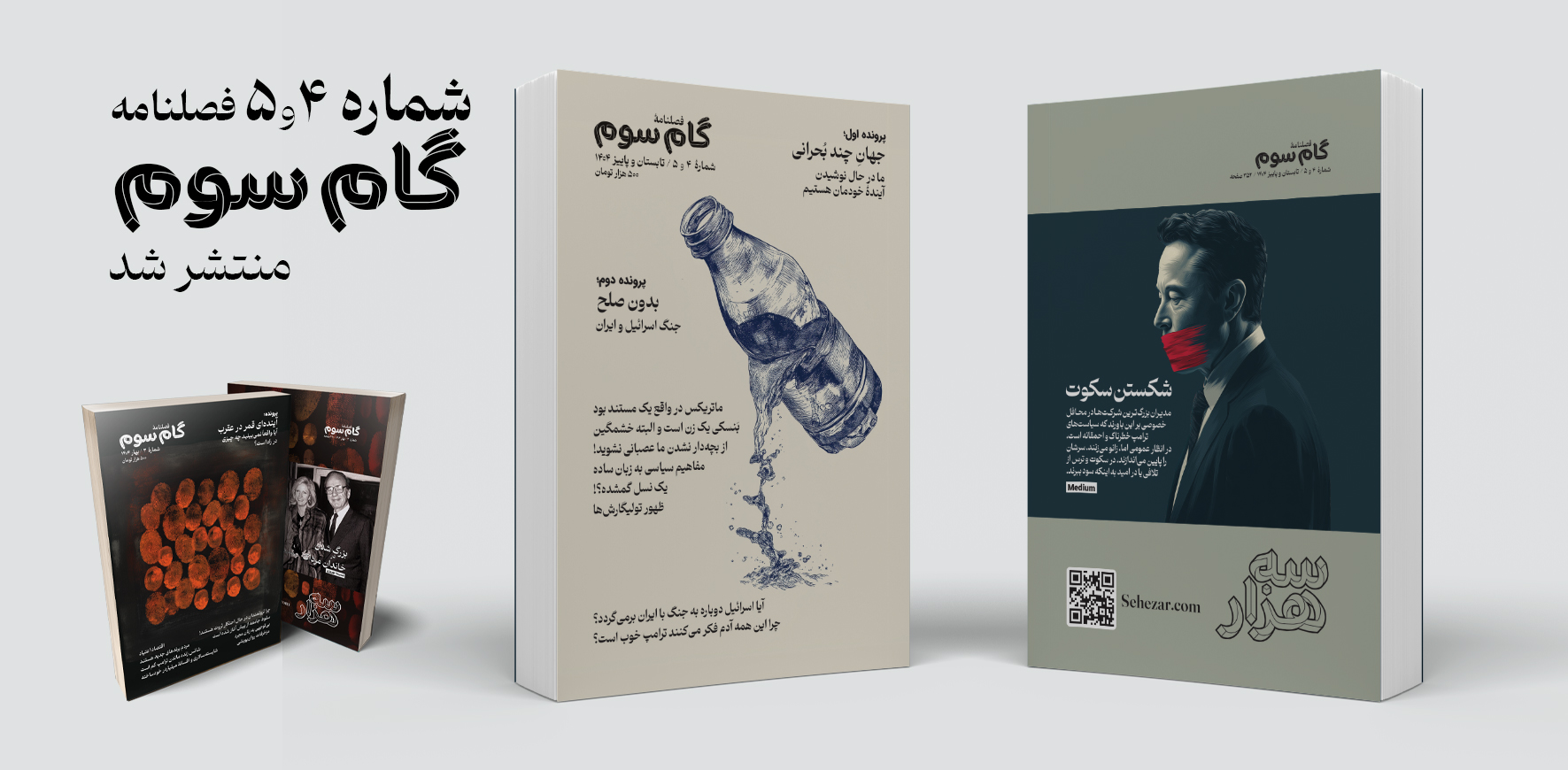

فصلنامه «گام سوم» شماره ۴ و ۵

در این نوبت از فصلنامه گام سوم دو شماره «۴ تابستان» و «۵ پاییز» بهطور همزمان منتشر شده است که همچون شمارههای پیشین شامل مقالات متنوعی در موضوعات اقتصاد، آینده مشاغل، خانواده، نوشتار و سیاست به همراه دو پرونده با موضوعات داغ روز میشود.

۱۳ رفتار غیرمعمول مدیران موفق که شاید شما را شگفتزده کند!

ادارهی یک شرکت کاری پر استرس است، بهویژه اگر یکی از بزرگترین شرکتهای جهان را مدیریت کنید. این میزان بالای استرس میتواند به عادتهای روزانهی شدید و غیرمعمول منجر شود. در ادامه، برخی از عجیبترین روالهای روزانهی مدیرعاملها آمده است.

چرا نترسیدن شرط یافتن پاسخهای مهم است؟

فهمیدم سلامت روانم بهتر شده است، وقتی به خارج از کشور رفتم و دیگر دچار شوک فرهنگی نشدم.من بخش زیادی از خودم را در دخترانم میبینم. آنها مشتاقاند وظایفشان را درست انجام دهند و اگر احساس کنند چیزی ممکن است «نامناسب» به نظر برسد، ناراحت و آشفته میشوند.

داستان های علمی تخیلی؛ پلی میان تخیل و ارتباط علمی مؤثر

وقتی وارد دوره دکترایم شدم، میدانستم به همان اندازه که از انجام پژوهش لذت میبرم، عاشق انتقال علم به عموم مردم نیز هستم. اما خیلی زود پژوهش بیشتر وقت مرا بلعید. اغلب تا نیمههای شب کار میکردم و بیشتر آخر هفتههایم صرف آمادهسازی آزمایشها، گردآوری دادهها یا جبران عقبماندگی از انبوه پایانناپذیر مقالات علمی روی میزم میشد.

پربازدیدترین مطالب

جهان خسته از نابرابری و ثروتمندان

با تشدید بحرانهای محیطزیستی، اجتماعی و انسانی، جهان دیگر قادر به تحمل دو چیز نیست: ۱- هزینههای نابرابری اقتصادی ۲- جامعه ثروتمندان. کاهش نابرابری اقتصادی بهتنهایی درمانی برای این بحرانهای جهانی نیست، اما نقش محوری در حل همه آنها دارد.

روند ۱۰۰ ساله تغییر اشتغال زنان به روایت تصویر

نگاهی به تصاویر صد سال گذشته نشان میدهد که زنان چگونه از جنگهای جهانی تا قرن ۲۱، توانستند مرزهای شغلی را جابهجا کنند و مسیر جدیدی در تاریخ نیروی کار رقم بزنند.

هوش مصنوعی و سیاست: چگونه بفهمیم چه چیزی و چه کسی واقعی است؟

اگر خوششانس باشیم، فناوریهای جدید فقط باعث سردرگمی مختصری میشوند. وگرنه، حوزه سیاسی ما میتواند برای همیشه تغییر کند.

نویسنده: آنا لویی ساسمن مترجم: نیوشا امیدی ۲۶ خرداد ۱۴۰۴

چگونه دیپفیکهای سیاسی را شناسایی کنیم؟

سواد رسانهای در حوزه هوش مصنوعی و مقدار مناسبی از شهود انسانی میتواند ما را تا حد زیادی یاری کند. با گسترش فناوری هوش مصنوعی، تولید ویدیوها، تصاویر و فایلهای صوتی دیپفیک قانعکننده روز به روز ارزانتر و آسانتر میشود. این موضوع پیامدهایی برای عرصه سیاست دارد، جایی که دیپفیکها ممکن است به پدیدهای رایجتر در یک زیستبوم اطلاعاتی از پیش دچار تفرقه تبدیل شوند.

این مطلب نوشتهای است از آنا لویی ساسمن که در تاریخ۱ ژوئیه ۲۰۲۴ با عنوان

How to Spot Political Deepfakes

در وبسایت Kellogg Insight منتشر شده است.

خلاصه

با گسترش فناوری هوش مصنوعی، تولید ویدیوها، تصاویر و فایلهای صوتی دیپفیک قانعکننده روز به روز ارزانتر و آسانتر میشود. این موضوع پیامدهایی برای عرصه سیاست دارد، جایی که دیپفیکها ممکن است به پدیدهای رایجتر در یک زیستبوم اطلاعاتی از پیش دچار تفرقه تبدیل شوند. برای کمک به مردم در تمایز میان محتوای واقعی و دیپفیک سیاسی، دانستن علائم هشداردهنده مفید است. این مقاله نکاتی دربارۀ تعریف و شناسایی دیپفیکها، درک جایگاه آنها در رسانههای کنونی، و اعتماد به شهود خود هنگام بررسی جزئیات رسانهای برای نشانههای احتمالی دستکاری ارائه میدهد.

در ایالات متحده، فصل انتخابات ریاستجمهوری آغاز شده است. رأیدهندگان میتوانند انتظار همان چیزهای همیشگی را داشته باشند: صندوقهای پستی پر از بروشور، تبلیغات تلویزیونی تندوتیز، و پیامکهایی با لحن دوستانه از سوی نامزدهای حوزههای انتخابیه محلی که درخواست کمک مالی دارند.

اما در این فصل انتخاباتی، ممکن است با پدیدهای تازه نیز روبهرو شویم. در ماه ژانویه، یک تماس تلفنی خودکار تولیدشده با هوش مصنوعی که ادعا میکرد صدای جو بایدن، رئیسجمهور، است، از رأیدهندگان نیوهمپشایر خواست تا در انتخابات مقدماتی شرکت نکنند؛ اگر دیپفیکها به بخش گستردهتری از چشمانداز انتخاباتی بدل شوند، ممکن است در زیستبوم اطلاعاتی از پیش دچار شکاف، سردرگمی ایجاد کنند.

فناوری تولید این دیپفیکها هر روز در حال پیشرفت است. مت گرو، استادیار مدیریت و سازمانها در مدرسه کلاگ، نگران کمک به مردم برای تشخیص واقعیت از جعلیات در فضای آنلاین و جلوگیری از فریب خوردن توسط دیپفیکهاست. او در پژوهشهای خود دریافته است که مردم، وقتی با دقت توجه کنند، توانایی خوبی در شناسایی دیپفیکها دارند.

در پژوهشهایی که با ویدیوهای دیپفیک از بایدن و ترامپ انجام داده، بیشتر افراد در تمایز بین محتوای واقعی و جعلی دقت نسبتاً بالایی داشتند.

در اینجا، گرو به رمزگشایی از دیپفیکها میپردازد. او توضیح میدهد که چرا احتمالاً به این زودی با سیل عظیمی از آنها روبهرو نخواهیم شد و توصیههایی برای شناسایی آنها در فضای واقعی ارائه میدهد.

اصلاً دیپفیک چیست؟

اصطلاح «دیپفیک» ترکیبی از «یادگیری عمیق» (روشی از هوش مصنوعی که از طریق دادههای چندلایه به شناسایی الگوها میپردازد) و «جعلی» (محصول شبیهسازیشده چنین یادگیری) است.

اما واقعاً چه چیزی «دیپفیک» محسوب میشود؟ به گفته گرو، تعریف دقیق و مورد توافقی برای آن وجود ندارد. او میگوید: «کمی به حس و حال بستگی دارد.» تعریف کاری او این است: «رسانهای تولیدشده با هوش مصنوعی (اغلب ویدیو) که باعث میشود فردی به نظر برسد که کاری کرده یا چیزی گفته که در واقعیت چنین نبوده»، ولی بسیاری از مردم به طور کلی آن را به عنوان دستکاری واقعیت در رسانه در نظر میگیرند.

اما گرو بهسرعت یادآوری میکند که، هرچند این اصطلاح جدید است، بخش «جعلی» آن دهههاست با ما بوده است.

جوزف استالین بدنام، دشمنانش را از عکسها حذف میکرد و پوست چهرهاش را در تصاویر صاف میکرد. نشنال جئوگرافیک تصویری از اهرام جیزه را در روی جلد خود دستکاری کرده بود. چهره آبراهام لینکلن توسط یک حکاک خلاق بر بدن جان سی. کلهون جایگذاری شده بود. سال گذشته، رأیدهندگان اسلواکی صدای دیپفیکشده نامزدی را شنیدند که ظاهراً درباره تقلب در آرا و افزایش قیمت آبجو صحبت میکرد.

درک گستره دیپفیکهای سیاسی

با این حال، گرچه فناوری بدون شک امکان تولید دیپفیکها را فراهم کرده، تصور اینکه اینترنت در حال حاضر پر از تصاویر و ویدیوهای جعلیِ دشوار برای شناسایی است، صرفاً نادرست است. گرو میگوید دلیل آن این است که تولید ویدیوهای دیپفیک قانعکننده هنوز بسیار دشوار است و نیاز به صرف زمان، منابع و مهارت فراوان دارد. تعویض چهره—استفاده از فناوری برای جایگذاری چهره افراد در عکسها یا ویدیوها—نسبتاً ساده است، اما تولید دیپفیکهای واقعیگرایانه ویدئویی (فراتر از ویدیوهای ساده با چهره متکلم، مانند آنچه در HeyGen تولید میشود) مستلزم هماهنگی عوامل زیادی است.

گرو میگوید: «موضوع فقط این نیست که بگوییم “اوه، این یک ویدیوست، بیایید آن را وارد یک الگوریتم کنیم؛ حالا شد یک دیپفیک و تمام.”»

«عناصر انسانی زیادی در این فرایند دخیلاند.»

برای نمونه، حتی برای یک دیپفیک صوتی مانند تماس رباتیک منسوب به بایدن، یک کلاهبردار باید کار را با یک مجموعهداده صوتی مناسب آغاز کند—کلیپهایی بدون نویز پسزمینه که با لحنی دقیقاً مشابه صحبت شدهاند—تا بتواند یک دیپفیک قانعکننده تولید کند.

برای نشان دادن میزان پیچیدگی این فرایند، گرو به مجموعهای از دیپفیکهای تام کروز در یک حساب تیکتاک به نام deeptomcruise اشاره میکند که اکنون بیش از پنج میلیون دنبالکننده دارد. این ویدیوها بازیگری شبیه به تام کروز را نشان میدهند، ماهها کار برای آموزش مدل بر پایه یک مجموعهداده عظیم از بازیها و حضورهای رسانهای تام کروز، جلوههای بصری، و همچنین کار فریم به فریم برای پاکسازی ناسازگاریها—علاوه بر الگوریتم دیپفیک.

گرو میگوید: «اگر درک کنیم که این چیزها چگونه ساخته میشوند، میتوانیم بفهمیم چقدر دشوار است که به این شکل تولید شوند و چقدر تلاش انسانی برای فریب متقاعدکننده لازم است.»

«اگر دیپفیکهای بینقص به این میزان تلاش نیاز دارند، پس با سیلی از رسانههای مصنوعی که از واقعیت غیرقابل تمایز باشند—آنطور که بسیاری انتظار دارند روبرو نخواهیم شد.»

به شهود خود اعتماد کنید، مکث کنید، و زمینه را در نظر بگیرید

ما همگی با این جمله معروف منسوب به توماس فولر، کشیش قرن هفدهم، آشنا هستیم که میگوید: «دیدن، باور کردن است.» اما نیمه دوم این جمله، که اغلب نادیده گرفته میشود، شاید در تشخیص دیپفیکها آموزندهتر باشد: «دیدن، باور کردن است، اما حس کردن، حقیقت است.»

خودِ عمل مکث کردن برای دقیقتر دیدن یا شنیدن رسانههای آنلاین، به افراد این فرصت را میدهد که به شهود خود رجوع کنند و احتمال گرفتار شدن در دام یک دیپفیک را کاهش دهند.

در ویدیویی از نرمافزار هوش مصنوعی Sora، کلیپ کوتاهی که با عبارت «زنی در حال قدم زدن در خیابانی در توکیو» تولید شده، در نگاه اول بسیار واقعی به نظر میرسد—تا زمانی که حدود ۱۵ ثانیه از ویدیو میگذرد و پاهای زن حرکتی عجیب (و از نظر فیزیولوژیکی ناممکن) انجام میدهد؛ نوعی چرخش لغزنده در حین قدم زدن. گرو توضیح میدهد که این مثال، نشان میدهد چگونه یک ابزار هوش مصنوعی که پیکسلها را بر اساس قواعد شناسایی الگوها میچیند، ممکن است از محدودیتهای واقعیت چشمپوشی کند. دانستن این موضوع، تشخیص اینگونه اختلالات را آسانتر میکند.

او میگوید: «ما قواعدی را میدانیم درباره اینکه انسان چگونه باید رفتار کند—چه از نظر اجتماعی، چه فیزیولوژیکی، یا هر چیز دیگر—اما همچنین میدانیم که مدل لزوماً این قواعد را نمیداند؛ بلکه صرفاً الگوهای آن قواعد را میشناسد.»

«وقتی این حرکات عجیب ظاهر میشوند، اینجاست که انسان بودن و داشتن عقل سلیم واقعاً به کار میآید.»

گرو میگوید همیشه در جهان دروغگو وجود داشته و ما همیشه ناچار بودهایم با تکیه بر تواناییهای انسانی خود آنها را شناسایی کنیم. یکی از نکات مهم این است که محتوای سادهی گفتاری یا نوشتاری—آنچه گفته میشود—شاید برای شناسایی دیپفیکها کمتر مفید باشد نسبت به نشانههای غیرکلامی و بصریای که پیرامون آن پیام وجود دارد.

گرو میگوید: «انسانها به روشهای بسیار متنوعی تعامل میکنند. تجربه یعنی اینکه چطور بو میکنید، چطور مزه میکنید، چطور میشنوید، چطور به مسائل با دید انتقادی نگاه میکنید. همهی این عوامل مختلف به ما کمک میکنند تا واقعیت خود را بسازیم و واقعیت را از جعل تشخیص دهیم.»

درک کنید که دیپفیک چگونه کار میکند؛حتی با ساختن نسخهی خودتان

زمانی که گرو کلاس هوش مصنوعی خود را تدریس میکند، با تعریف سادهای آغاز میکند که دانشجویان به راحتی درک کنند: «حل مسئله با رایانهها.»

ممکن است دانشجویی بپرسد: «خب، این که شامل همه چیز میشود!»

گرو پاسخ میدهد که این دقیقاً نکتهی اصلی است—چون دانشجویان پیشتر با رایانهها کار کردهاند، از فناوری هوش مصنوعی کمتر هراس دارند و نسبت به تبلیغات بازاریابی آن دیدی انتقادیتر پیدا میکنند.

به همین ترتیب، هرچه فرد بیشتر با فناوری دیپفیک کار کند، محدودیتهای آن نیز برایش آشکارتر میشود. به همین دلیل است که گرو معتقد است افراد مسنتر شاید کمتر از همتایان جوانتر خود توانایی تشخیص دیپفیکها را داشته باشند، چرا که نسل جوان احتمالاً با ابزارهایی مانند فیسسوَپ یا اپلیکیشنهایی مانند Facetune که قابلیت ویرایش عکس و ویدیو را دارند، رشد کردهاند.

گرو میگوید: «سن ما با نحوه تعاملمان در فضای مجازی و نوع محتوایی که مصرف میکنیم مرتبط است.»

آموزش سواد دیجیتال، یاد دادن نحوه استفاده از ابزارهای هوش مصنوعی، و دادن فرصت به افراد برای کار با این ابزارها، میتواند به آنها کمک کند تا تواناییهای این فناوریها و نقاط ضعفشان را درک کنند و در نتیجه در مواجهه با فریبها عملکرد بهتری داشته باشند.

برای مثال، جعل دستها بسیار سختتر از چهرههاست، چرا که تصاویر فراوانی از چهرهها برای آموزش مدلهای هوش مصنوعی در دسترس است، اما تصاویر باکیفیت کمتری از دستها وجود دارد. بنابراین، یکی از راههای شناسایی دیپفیکها بررسی دست افراد در ویدیوها برای مشاهده موارد غیرعادی است—از کفدستهایی غیرطبیعی بلند گرفته تا انگشتان اضافی.

او میگوید: «هرچه سواد هوش مصنوعی را بیشتر به سواد رسانهای بیفزاییم، مردم کمتر فریب میخورند.»

گرو به همراه همکارانش نگار کمالی، کارین ناکامورا، آنجلوس چاتزیمپارمپس و جسیکا هالمن از دانشگاه نورثوسترن، راهنمای آموزشیای برای تمایز تصاویر تولیدشده با هوش مصنوعی از عکسهای واقعی منتشر کردهاند.

و فراموش نکنید که همچنان باید به مهارتهای پایهای سواد رسانهای و تفکر انتقادی نیز تکیه کرد. گرو میگوید: «منبع چیست؟ قصد دارد مرا به چه چیزی متقاعد کند؟ چرا ممکن است این محتوا واقعی یا جعلی باشد؟» اینها همه پرسشهایی هستند که باید هنگام مواجهه با محتوای سیاسی در نظر گرفت.

درباره نویسنده:

آنا لویی ساسمن؛ نویسندهای سایت Kellogg Insight

درباره محقق:

متیو گرو؛ استادیار مدیریت و سازمانها و از اعضای برجسته هیئت علمی