جدیدترین مطالب

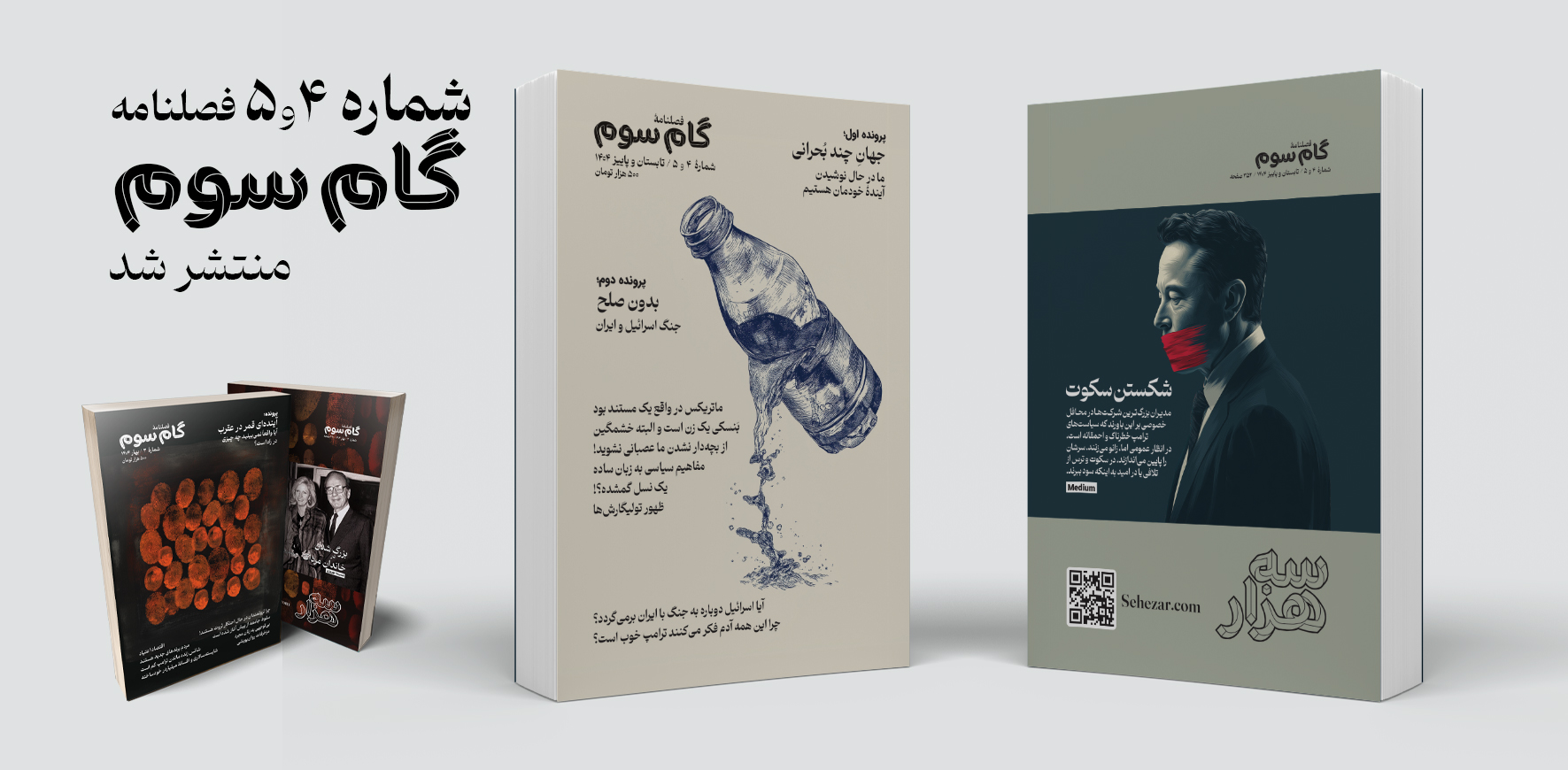

فصلنامه «گام سوم» شماره ۴ و ۵

در این نوبت از فصلنامه گام سوم دو شماره «۴ تابستان» و «۵ پاییز» بهطور همزمان منتشر شده است که همچون شمارههای پیشین شامل مقالات متنوعی در موضوعات اقتصاد، آینده مشاغل، خانواده، نوشتار و سیاست به همراه دو پرونده با موضوعات داغ روز میشود.

۱۳ رفتار غیرمعمول مدیران موفق که شاید شما را شگفتزده کند!

ادارهی یک شرکت کاری پر استرس است، بهویژه اگر یکی از بزرگترین شرکتهای جهان را مدیریت کنید. این میزان بالای استرس میتواند به عادتهای روزانهی شدید و غیرمعمول منجر شود. در ادامه، برخی از عجیبترین روالهای روزانهی مدیرعاملها آمده است.

چرا نترسیدن شرط یافتن پاسخهای مهم است؟

فهمیدم سلامت روانم بهتر شده است، وقتی به خارج از کشور رفتم و دیگر دچار شوک فرهنگی نشدم.من بخش زیادی از خودم را در دخترانم میبینم. آنها مشتاقاند وظایفشان را درست انجام دهند و اگر احساس کنند چیزی ممکن است «نامناسب» به نظر برسد، ناراحت و آشفته میشوند.

داستان های علمی تخیلی؛ پلی میان تخیل و ارتباط علمی مؤثر

وقتی وارد دوره دکترایم شدم، میدانستم به همان اندازه که از انجام پژوهش لذت میبرم، عاشق انتقال علم به عموم مردم نیز هستم. اما خیلی زود پژوهش بیشتر وقت مرا بلعید. اغلب تا نیمههای شب کار میکردم و بیشتر آخر هفتههایم صرف آمادهسازی آزمایشها، گردآوری دادهها یا جبران عقبماندگی از انبوه پایانناپذیر مقالات علمی روی میزم میشد.

پربازدیدترین مطالب

جهان خسته از نابرابری و ثروتمندان

با تشدید بحرانهای محیطزیستی، اجتماعی و انسانی، جهان دیگر قادر به تحمل دو چیز نیست: ۱- هزینههای نابرابری اقتصادی ۲- جامعه ثروتمندان. کاهش نابرابری اقتصادی بهتنهایی درمانی برای این بحرانهای جهانی نیست، اما نقش محوری در حل همه آنها دارد.

روند ۱۰۰ ساله تغییر اشتغال زنان به روایت تصویر

نگاهی به تصاویر صد سال گذشته نشان میدهد که زنان چگونه از جنگهای جهانی تا قرن ۲۱، توانستند مرزهای شغلی را جابهجا کنند و مسیر جدیدی در تاریخ نیروی کار رقم بزنند.

انواع هوش، کاربردهای هوش هیجانی و تقویت آن در کودکان

ین مطلب نگاهی دارد به انواع هوش و نقش مهم آنها در زندگی روزمره و تواناییهای شناختی انسان. همچنین مروری بر هوش هیجانی و کاربردها و روشهای تقویت آن در کودکان.

نویسنده: کالین هورگان ۴ اردیبهشت ۱۴۰۳

هوش مصنوعی و سیاست: چگونه بفهمیم چه چیزی و چه کسی واقعی است؟

اگر خوششانس باشیم، فناوریهای جدید فقط باعث سردرگمی مختصری میشوند. وگرنه، حوزه سیاسی ما میتواند برای همیشه تغییر کند.

این مطلب نوشتهای است از کالین هورگان که در تاریخ ۱۳ اکتبر ۲۰۲۳ با عنوان

AI and Politics: How Will We Know What—and Who—Is Real

در وبسایت The Walrus منتشر شده است. ترجمه این مطلب توسط تیم سههزار انجام شده و در اختیار خوانندگان گرامی قرار میگیرد.

در ژانویه، حزب آلبرتا که یک حزب استانی میانهرو است، ویدئویی را در حساب رسمی اینستاگرام خود منتشر نمود. در آن ویدیو که همان موقع حذف شد ولی هنوز در فید توییتر آنها موجود است، مردی بود با ژاکت آبی رو به دوربین با نمایی از افق شهر کلگری در پشت سرش. حالتش مشکوک بود. آن مرد قبل از اینکه آلبرتیها به دنبال «گزینه دیگری» در روز انتخابات باشند، قاطعانه گفت «آیا آلبرتا به حزب سیاسی سوم نیاز دارد؟ به این بستگی دارد که از انتخابهای فعلی خود راضی هستید یا خیر؟»، دهانش به درستی حروف صدادار را ادا نمیکرد و چهرهاش به طرز عجیبی بیحرکت بود. همچنین صدایش که کاملا انسانگونه به نظر نمیرسید.

بخاطر اینکه او انسان نبود و آن ویدیو با هوش مصنوعی تولید شده بود. حزب آلبرتا در پستی که از آن زمان حذف شده بود، تصریح کرد که «آن چهره یک هوش مصنوعی است، اما کلمات توسط یک شخص واقعی نوشته شدهاند». این اپیزودی ناراحت کننده بود، برخلاف یکی از اپیزودهای سریال موفق تکنو – دیستوپیایی Black Mirror که در آن یک خرس انیمیشن آبی رنگ به نام والدو، با صداپیشگی یک کمدین، به عنوان یک نامزد ضد نظام در انتخابات میان دورهای بریتانیا شرکت میکند.

توماس جفرسون در زمستان 1789 نوشت: «… هر جا مردم به خوبی آگاه باشند، میتوانند به دولت خودشان اعتماد کنند». به عبارت دیگر، در یک دموکراسی، آگاه بودن مردم را دارای نماینده میکند، و نماینده داشتن به ما صدایی رسا میدهد.

هوش مصنوعی این پتانسیل را دارد که هر دوی این مفروضات حیاتی را که صدها سال در قلب درک ما از دموکراسی جاسازی شدهاند، به چالش بکشد. چه اتفاقی میافتد وقتی بلندترین یا تأثیرگذارترین صدا در سیاست، صدایی باشد که توسط رایانه ایجاد شود؟ و چه اتفاقی میافتد وقتی آن صدای ساخته شده توسط رایانه نیز شبیه یک انسان به نظر میرسد؟ اگر خوش شانس باشیم، صدا و ویدیوی تولید شده یا دستکاری شده با هوش مصنوعی تنها لحظات کوتاهی از سردرگمی مجزا در حوزه سیاسی ما ایجاد میکند. وگرنه، این خطر وجود دارد که سیاست – و جامعه – را برای همیشه به هم بزند.

چیزی که من را میترساند این است که ما به دام آنها نمیافتیم، یا بسیاری از ما به آنان علاقه نداریم. اما آنها یکی یکی در طول زمان ظاهر میشوند و ما دائماً در حال دعوا هستیم که آیا آخرین نمونه از این موارد را باور میکنیم یا نه.

بخش عمدهای از سرنوشت ما به آشنایی با آنچه می بینیم بستگی دارد. برای مثال رباتها را در نظر بگیرید. این برنامههای خودکار یا نیمهخودکار از هوش مصنوعی پشتیبانی میکنند و پلتفرمهای رسانههای اجتماعی در حال حاضر مملو از آنها هستند. آنها معمولاً برای جعل کردن تعداد فالوورها، پاسخگویی خودکار به سؤالات مشتری و ارائه بهروزرسانیهای اخبار فوری استفاده میشوند. نگرانکنندهتر اینکه، آنها همچنین در کمپینها برای تأثیرگذاری بر بحث عمومی یا در برخی موارد، آزار و اذیت مردم استفاده میشوند. اما این نوع رباتها بر پایه متن باقی میمانند. آنچه حزب آلبرتا ایجاد کرد، و آنچه دیگران میسازند، بسیار متفاوت است. زیرا که دیدار و شنیدار ما را به چالش میکشند.

در سال 2018، جردن پیل، بازیگر و کارگردان، اجازه داد صدایش به صورت دیجیتالی تغییر داده شود و سپس با یک ویدیوی دستکاری شده از باراک اوباما ادغام گردد، به طوری که به نظر میرسید انگار رئیس جمهور سابق ایالات متحده در واقع فیلمنامه پیل را روخوانی میکند. این نوع ویدیو با هوش مصنوعی مولد ساخته میشود که به آن «دیپ فیک» میگویند. آن ویدیو به عنوان هشداری در برابر احتمال کمپینهای اطلاعات غلط تصنعی (ساختگی) در آینده، از جمله انتخابات 2020 ایالات متحده ایجاد شد. اما آن انتخابات بدون هیچگونه سردرگمی قابل توجه ناشی از هوش مصنوعی گذشت. در عوض شبکه NPR (National Public Radio) آن سال در تلاشی برای توضیح عدم وجود دیپفیک نتیجهگیری کرد که «فریبهای ساده مانند ویرایش انتخابی (روایتهای گزینشی) یا دروغهای صریح به خوبی جواب دادهاند».

اما در آن زمان، محدودیتهای فنی و هزینهای وجود داشت. به گفته یک کارشناس: «نمیشود فقط با دانلود یک برنامه … و یک چیزی شبیه فیلمنامه و یک نفر که آن حرفها را بزند، بشود ویدیویی در قالب دیپفیک ساخت. شاید در چند سال آینده [به آن نقطه برسیم]، آن موقع درست کردن دستکاریهای قانعکننده به طور بالقوهای بسیار آسان خواهد بود.»

ما الان آنجا هستیم.

در ماه فوریه، یک حساب کاربری اینستاگرام ویدئویی را منتشر کرد که در آن ظاهراً جو بایدن، رئیس جمهور آمریکا، اظهارات توهینآمیزی در مورد زنان تراجنسیتی میکند. صدای آن با استفاده از یک برنامه هوش مصنوعی که صداهای واقعی را تقلید میکند، تولید شده است. آن ویدیو در رسانههای اجتماعی به عنوان یک «ویدیو تغییر یافته» علامتگذاری شد، اما مورد توجه قرار گرفت و توسط برخی رسانههای راستگرای آمریکایی بازنشر شد. حتی حامیان بایدن هم صدای او را جعل کردند. تامی ویتور، یکی از کارمندان کاخ سفید در دوران دولت اوباما، قبل از پخش کلیپی که چیزی شبیه بایدن بود، گفت: «آخر هفته با یک دوست بسیار مهم برخورد کردم. ویتور خیلی زود اعتراف کرد که برای ساخت این کلیپ 5 دلار در سایت elevenlabs پرداخت کرده است.»

تفاوت مهمی بین دیپفیک حزب آلبرتا (شخصی که کاملاً توسط رایانه ساخته شده) با نمایش صوتی و تصویری ترکیب شده از یک انسان واقعی مانند رئیس جمهور فعلی، وجود دارد. با این حال، واکنش به هر دو یکسان است: مردم گیج میشوند. یکی از دلایل آن ناآشنایی است. به گفته الیزابت دوبویس، رئیس دانشگاه در سیاست، ارتباطات و فناوری و دانشیار دانشگاه اتاوا: «یکی از چیزهای کلیدی، سواد دیجیتال از دیدگاه عمومی است. همچنانکه این نوآوریها بیشتر در کمپینها گنجانده میشوند… مردم نیز به طور کلی در مورد آنچه اتفاق میافتد و نحوه نمایش، باسواد میگردند. اما در مراحل اولیه وقوع این آزمایش، بیشترین احتمال وجود دارد که مردم واقعا متوجه نشوند چه اتفاقی در حال رخ دادن است.»

مشکل بسیاری از این فناوریها این است که به جای متقاعد نمودن با استدلال و اطلاعات، جنبه دستکاریکنندهتر (تحریفگر) را توانمند میسازند. کاری که شما انجام میدهید این است که با مردم بهعنوان سوژههایی مستقل و روشنفکر رفتار نمیکنید.

اما رسانههای تحت (نفوذ) دستکاری نیز مهم هستند. رجینا رینی، استاد تحقیقاتی کانادایی در استدلال اجتماعی دانشگاه یورک میگوید: «این ویدئوها با بررسی صوتی و تصویری، انتظارات اجتماعی را در مورد رابطهای که هر دو با حقیقت عینی دارند، افزایش میدهند. از نظر فنی، رباتها چیزهایی را به صورت شفاهی یا با استفاده از متن میگویند. و در حالی که ما معمولاً درک ذاتی داریم که اظهارات شفاهی یا نوشتاری میتواند نادرست، اشتباه یا فریبنده باشد، کمتر تمایل داریم که در مورد رسانههای دیداری و شنیداری شکاک باشیم. همه میدانند که امکان جعل عکسهای سنتی وجود دارد … میدانیم که میتوان با ویدیوها تحریف کرد. اما درجه شک و تردید پیشفرض برای ضبطهای صوتی و تصویری بسیار کمتر بوده است.» هوش مصنوعی مولد در حال تغییر این درک و باور است.

این امکان وجود دارد که معرفی تدریجی ویدیو و صدای دستکاری شده با هوش مصنوعی در گفتمان روزمره، عموم مردم را با آن سازگار کند، همانطور که ما به رباتهای مبتنی بر متن عادت کردیم. از سوی دیگر، اگر تعداد زیادی از افراد برای ارزیابی صحت یک کلیپ ویدیویی یا صوتی نیاز باشد و ما آماده نباشیم، جهنمی برپا خواهد شد.

رینی بهعنوان مثال میگوید: «سناریوی وحشتآمیز این است که اگر قرار باشد یک ویدیوی فریبنده با پیامدهای ژئوپلیتیک قابل توجهی در فضای مجازی پخش شود، چیزی شبیه مکالمه جعلی جو بایدن و ولادیمیر پوتین، که میتواند جنگها را آغاز کند.» اما حتی یک حرکت قطرهچکانی نیز میتواند اساس واقعیت مشترک ما را از بین ببرد. او میگوید: «چیزی که من را میترساند این است که ما به دام آنها نمیافتیم، یا بسیاری از ما به آنان علاقه نداریم. اما آنها یکی یکی در طول زمان ظاهر میشوند و ما دائماً در حال دعوا هستیم که آیا آخرین نمونه از این موارد را باور میکنیم یا نه. در نهایت اثر تجمعی بسیاری از نمونههای کوچک در طول زمان و برخی از موارد بزرگ، باعث میگردد به جایی برسیم که به طور کلی به رسانهها اعتماد نکنیم.»

اگر فکر میکنید این مسئله بعید به نظر میرسد، یک مثال خارج از حوزه سیاسی را در نظر بگیرید.

در ماه مارس، یک کلیپ ویدئویی از چیزی به نام Caba Baba Rave در توییتر پخش شد که توسط حسابهای کاربری راستگرایی مانند Libs of TikTok نیز تقویت گردید.

این ویدیوی وایرال شده، رویدادی را نشان میدهد که در آن اجراکنندگان، نمایشی را برای والدین کودکان بسیار کوچک برگزار میکنند. Caba Baba Rave آن را «نمایش کابارهای طراحی شده برای والدین، با لحظات حسی برای نوزادان» نامیده است. این کلیپ غوغایی به پا کرد، نه فقط به دلیل محتوای آن، بلکه بخاطر ادعای کاملاً جعلی بودن آن. خیلی زود یک گفتمان فرعی مفصل در مورد اینکه آیا کسی این ویدئو را برای بیان یک نکته ایدئولوژیک دستکاری کرده است، به وجود آمد. اما همانطور که کابا بابا ریو تایید کرد، آن ویدیو واقعی بود. با این وجود، برخی از کاربران هنوز آن را باور نمیکردند.

حتی زمانی که کاربران رسانههای اجتماعی متقاعد نشده باشند که ویدیوها دیپفیک هستند یا بهطور دیگری تحت تغییر قرار گرفتهاند، سطوح بررسی دقیق در حال حاضر فقط به خوشخیمترین کلیپها اختصاص داده شده است. بهویژه در TikTok، اشتهای سیریناپذیر برای بحث در مورد صحت ویدیو و صدا قابل مشاهده است. به عبارت دیگر، اینترنت دقیقاً برای نوع مبارزهای که رینی نسبت به آن هشدار میدهد آماده شده است؛ یک جنگ بی پایان فرا شکاکیت.

راه کمتر رایج دیگری وجود دارد که ممکن است در آن به نقطهای برسیم که چارچوب واقعیت فراتر از درک ما منحرف گردد. در حالی که هوش مصنوعی شرایط بحث عمومی آنلاین را تغییر میدهد، به روشهایی که کمتر قابل مشاهده هستند نیز به کار گرفته میشود.

در حال حاضر این امکان وجود دارد که راههای مشاوره عمومی، از جمله رسانههای اجتماعی، مملو از پیامهای تولید شده توسط رباتها باشد، اما هوش مصنوعی سناریوهای بالقوه مؤثرتری را ارائه میکند، که البته نگران کننده نیست.

صحنه سیاسی دوزبانه کانادا ممکن است نوع متفاوتی از فرصت را ارائه دهد – نه برای جعل نامزد، بلکه برای زبان. با دیپ فیک که باعث میشود یک نامزد انگلیسی زبان به زبان فرانسه مسلط گردد.

در اینجا یکی از تحقیقات منتشر شده در ماه فوریه از Nathan E. Sanders (دانشمند داده در مرکز برکمن کلاین در دانشگاه هاروارد) و Bruce Schneier (تکنولوژیست امنیتی در مدرسه کندی هاروارد) مرور میکنیم. یک فعال سیاسی (مثلاً یک شرکت لابی با منابع مالی فراوان) یک برنامه یادگیری ماشینی ایجاد میکند که برای ترسیم شبکه ای از قانونگذاران بر اساس موقعیت، ارشدیت، سطح، روند رأیگیری گذشته، اظهارات یا بسیاری از عوامل دیگر طراحی شده است و به شرکت اجازه میدهد تا تلاشهای لابی خود را بر روی آن دسته از سیاستمدارانی متمرکز کند که پیشبینی می شود بیشترین تأثیر را بر یک استراتژی قانونگذاری معین دارند.

نوعی ابزار که در پادکست به نمایش گذاشته میشود، امکان عجیبتری را ارائه میدهد. شاید شما آن مدل یادگیری ماشینی پیشبینیکننده را در سیستمی پنهان کنید که توانایی تماس با دفتر یک سیاستمدار را دارد و با استفاده از صدای ترکیبی و خودکار، درباره آن قانون گفتگو نماید. و شاید آن صدا بسیار شبیه یکی از اعضای آنها یا نخست وزیر باشد.

سندرز در حین گفتگوی ما پرسید: «چگونه از سوگیری و تحریف روند سیاسی ما جلوگیری میکنید؟ توصیه اساسی ما در آن رژیم این است که مشارکت مردم … و شنیده شدن صدای افراد واقعی را نیز آسانتر کنید.» سندرز خاطرنشان کرد که برخی از ابزارهای هوش مصنوعی در حال حاضر این کار را انجام می دهند، از جمله ابزارهایی مانند «مترجم گوگل»، که ارتباط برخی افراد با نمایندگانشان را با ترجمه پیامها از زبان مبدا به زبان مقصد سادهتر مینماید. (لوکیشن مقاله مربوط به کانادا است و احتمالا منظور ترجمه از فرانسه به انگلیسی و برعکس باشه)

واضح است که فناوری با سیاست بیگانه نیست. دوبوا میگوید: «باید انتظار داشته باشیم که با هر فناوری جدید، مردم تلاش کنند تا دریابند که آیا راهی برای بهتر، مؤثرتر و ارزانتر کردن سیاست وجود دارد یا خیر.» سندرز نیز با اشاره به ابزارهای موجود مانند ادغام نامه (روشی برای ارسال انبوه پیامهای شخصیسازی شده) که سالهاست از جانب احزاب سیاسی و نامزدها مورد استفاده قرار میگیرد، این موضوع را یادآوری مینماید که: «من فکر نمیکنم واقعا تفاوت چندانی باشد بین استفاده از ابزار هوش مصنوعی با تلاشتان برای یافتن سه یا چهار واقعیت در مورد خودتان و سپس ایجاد یه پیام شخصیتر.»

در کانادا، بهطور خاص در قانون انتخابات قوانینی که استفاده از هوش مصنوعی را در طول مبارزات سیاسی دیکته میکند، بیان نشده است. اما آژانس غیرحزبی Elections Canada قوانینی علیه جعل هویت یا نمایندگی نادرست به قصد گمراه کردن دارد. «نشریات گمراهکننده» نیز ممنوع است – این مورد شامل «هر مطلبی، صرف نظر از شکل آن» است که ادعا میکند از طرف رئیس انتخابات، مقامات برگزارکننده یا نامزد سیاسی باشد. به غیر از مواردی که ممکن است مربوط به جعل هویت یا انتشار گمراهکننده باشد، آژانس انتخابات کانادا در ایمیلی اعلام نموده است که «فعالانه در جستجوی دیپفیک، تصاویر و ویدئوهای جعلی نیست.»

اما Elections Canada فقط مربوط به دورههای انتخاباتی است. قانون دولت همه چیز دیگر را پوشش میدهد. با این حال، به نظر نمیرسد که استفاده از هوش مصنوعی برای مقاصد سیاسی در قانون جدید هوش مصنوعی کانادا که در پارلمان در جریان است، ذکر نشده باشد. و پیگیری از دفتر وزیر نوآوری، علم و صنعت که به دنبال توضیح بود، بی پاسخ ماند.

از نظر مارک کوکلبرگ، استاد فلسفه رسانه و فناوری در دانشگاه وین، هوش مصنوعی ممکن است کمک کند که متقاعدسازی معمولی به سوی قلمرو منفیتر متمایل گردد. او میگوید: «سیاستمداران به طور طبیعی سعی میکنند بر ما تأثیر بگذارند، اما مشکل بسیاری از این فناوریها این است که به جای متقاعد نمودن با استدلال و اطلاعات، جنبه دستکاریکنندهتر (تحریفگر) را توانمند میسازند. کاری که شما انجام میدهید این است که با مردم بهعنوان سوژههایی مستقل و روشنفکر رفتار نمیکنید … بلکه با آنها مانند موشهای آزمایشگاهی (یا هر نوع چیز دیگری) رفتار میکنید. سوژههایی که میتوانید در تبادل دادهها با آنها، اقدام به دستکاری نیز نمایید.»

واقعاً این دستکاری تا کجا میتواند پیش برود؟ سیاستمداران و نامزدهای سیاسی در حال حاضر قادرند به رایدهندگان دروغ بگویند. در یکی از پروندههای مطرح اخیر، جورج سانتوس جمهوریخواه اعتراف کرد که رزومهاش، که بر اساس آن برای یک کرسی در مجلس نمایندگان ایالات متحده مبارزات انتخاباتی کرده و برنده شده است، مملو از جعلهایی بود، از جمله درباره تحصیلات و تجربه کاری او. اگر یک انسان واقعی بتواند به این راحتی رأیدهندگان را فریب دهد، آیا یک انسان ساختگی هم میتواند همین کار را بکند؟

سال گذشته، حزب Synthetic، یک حزب دانمارکی که توسط یک گروه هنری و سازمان فناوری تأسیس شد، به دلیل تلاش برای نامزدی که توسط یک ربات چت هوش مصنوعی به نام Leader Lars رهبری میشد، جلب توجه نمود. بالفعل نمودن (عملیاتی شدن) یک نامزد واقعی تولید شده توسط هوش مصنوعی در یک حوزه انتخابی در کانادا، احتمالاً به سطحی از تقلب نیاز دارد. با این حال، سختترین موانع برای پیمایش – شناسایی (فهرست اسناد قابل قبول طولانی است ولی همه آنها نیاز به عکس ندارند) و 150 امضای توصیه شده از ساکنان حوزه انتخابی – غیر قابل حل نیستند. کمپین از طریق رسانههای اجتماعی خواهد بود. مناظرهها را میتوان نادیده گرفت، زیرا گاهی اوقات توسط نامزدهای واقعی انجام میشود. تحت این شرایط، آیا یک نامزد تولید شده توسط هوش مصنوعی میتواند مردم را متقاعد کند که به آن رای دهند بدون اینکه آنها متوجه جعلی بودن آن شوند؟

سندرز معتقد است که یک نامزد کامل هوش مصنوعی موفق نمیشود. او با اشاره به اینکه ما به عنوان یک جامعه میتوانیم قبل از وقوع چنین چیزی جلوی آن را بگیریم، میگوید: «فکر میکنم، به طور کلی، ممکن نیست.»

دوبوا سناریوی محتملتری را پیشنهاد میکند: «محتوای تقلید آمیز، مانند کلیپ جعلی جو بایدن، با ارتباط یک نامزد واقعی اشتباه گرفته میشود.» او میگوید: «میدانیم که وقتی مردم به سرعت پیمایش میکنند، گاهی اوقات گیج میشوند، متوجه برچسب نمیشوند، فکر میکنند واقعا بامزه است، بنابراین به هر حال آن را به اشتراک میگذارند. و به دلیل بازنشر، آنها تبدیل به منبع قابل اعتمادی برای شخص دیگری میشوند، و سپس شخص دیگری آن را میبیند. بنابراین شما میتوانید آن نوع اثر ضربه مدام را تصور کنید.»

رینی میگوید: «فکر میکنم کسی آن را امتحان کند، شاید به عنوان یک شیرین کاری.» موفقیت آن ممکن است وابسته به جغرافیا باشد، مانند یک منطقه روستایی که در آن رأیدهندگان ممکن است کمتر در رویدادهای حضوری شرکت کنند. یا ممکن است فقط به دنبال یافتن فرصت و مهمانی مناسب باشد. اگر یک جایگاه بسیار غیررقابتی را در ایالات متحده هدف قرار داده باشید … و به هر دلیلی که انتخابات مقدماتی مورد رقابت تنگاتنگ قرار نگرفت، [ممکن است] به نتیجه رساندن این امر سخت نباشد.» صحنه سیاسی دوزبانه کانادا ممکن است نوع متفاوتی از فرصت را ارائه دهد – نه برای جعل نامزد، بلکه برای زبان. با دیپ فیک که باعث میشود یک نامزد انگلیسی زبان به زبان فرانسه مسلط گردد. به نوبه خود، کوکلبرگ در مورد احتمال یک نامزد تولید شده توسط هوش مصنوعی مطمئنتر است: «کاملا. این اتفاق خواهد افتاد.»

در واقع، ممکن است نیازی به پنهان کردن آن نباشد. در حدود دو سوم مسیر اپیزود «لحظه والدو» از سریال Black Mirror، یک مدیر تلویزیون (جک)، با خالق انسان و صدای خرس کارتونی (جیمی)، در مورد مشروعیت والدو به عنوان نامزد بحث میکند. جیمی میگوید: «والدو واقعی نیست!» جک پاسخ میدهد: «دقیقا… او واقعی نیست، اما از بقیه واقعیتر است.» جیمی میگوید: «او هیچ چیز را تحمل نمیکند.» جک میگوید: «خب، حداقل او تظاهر نمیکند!»

این احتمال وجود دارد که همه ما در نهایت طرفدار جک شویم و دیگر در مورد اعتقادات سیاسی خود بحث نکنیم، بلکه در مورد اینکه آیا اصلاً میتوانیم چیزی را باور کنیم – چه رسد به اینکه به آن اعتقاد داشته باشیم، بحث کنیم. همچنین این احتمال وجود دارد که ما این بحث را به بحث در مورد واقعیت ترجیح دهیم. به هر حال ممکن است آن را جذابتر بدانیم.

درباره نویسنده:

کالین هورگان؛ نویسنده و متخصص ارتباطات در تورنتو