جدیدترین مطالب

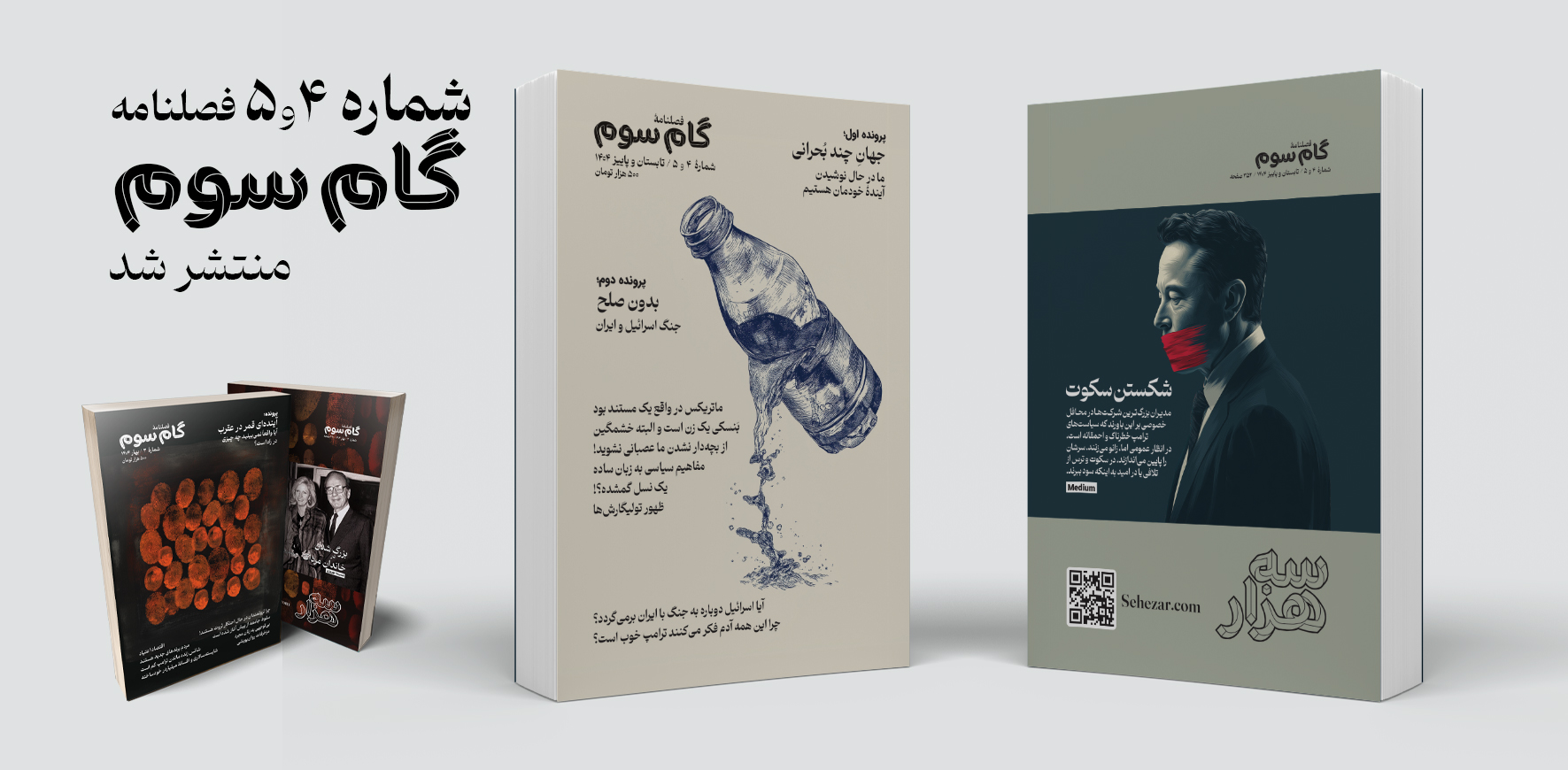

فصلنامه «گام سوم» شماره ۴ و ۵

در این نوبت از فصلنامه گام سوم دو شماره «۴ تابستان» و «۵ پاییز» بهطور همزمان منتشر شده است که همچون شمارههای پیشین شامل مقالات متنوعی در موضوعات اقتصاد، آینده مشاغل، خانواده، نوشتار و سیاست به همراه دو پرونده با موضوعات داغ روز میشود.

۱۳ رفتار غیرمعمول مدیران موفق که شاید شما را شگفتزده کند!

ادارهی یک شرکت کاری پر استرس است، بهویژه اگر یکی از بزرگترین شرکتهای جهان را مدیریت کنید. این میزان بالای استرس میتواند به عادتهای روزانهی شدید و غیرمعمول منجر شود. در ادامه، برخی از عجیبترین روالهای روزانهی مدیرعاملها آمده است.

چرا نترسیدن شرط یافتن پاسخهای مهم است؟

فهمیدم سلامت روانم بهتر شده است، وقتی به خارج از کشور رفتم و دیگر دچار شوک فرهنگی نشدم.من بخش زیادی از خودم را در دخترانم میبینم. آنها مشتاقاند وظایفشان را درست انجام دهند و اگر احساس کنند چیزی ممکن است «نامناسب» به نظر برسد، ناراحت و آشفته میشوند.

داستان های علمی تخیلی؛ پلی میان تخیل و ارتباط علمی مؤثر

وقتی وارد دوره دکترایم شدم، میدانستم به همان اندازه که از انجام پژوهش لذت میبرم، عاشق انتقال علم به عموم مردم نیز هستم. اما خیلی زود پژوهش بیشتر وقت مرا بلعید. اغلب تا نیمههای شب کار میکردم و بیشتر آخر هفتههایم صرف آمادهسازی آزمایشها، گردآوری دادهها یا جبران عقبماندگی از انبوه پایانناپذیر مقالات علمی روی میزم میشد.

پربازدیدترین مطالب

جهان خسته از نابرابری و ثروتمندان

با تشدید بحرانهای محیطزیستی، اجتماعی و انسانی، جهان دیگر قادر به تحمل دو چیز نیست: ۱- هزینههای نابرابری اقتصادی ۲- جامعه ثروتمندان. کاهش نابرابری اقتصادی بهتنهایی درمانی برای این بحرانهای جهانی نیست، اما نقش محوری در حل همه آنها دارد.

روند ۱۰۰ ساله تغییر اشتغال زنان به روایت تصویر

نگاهی به تصاویر صد سال گذشته نشان میدهد که زنان چگونه از جنگهای جهانی تا قرن ۲۱، توانستند مرزهای شغلی را جابهجا کنند و مسیر جدیدی در تاریخ نیروی کار رقم بزنند.

هوش مصنوعی و سیاست: چگونه بفهمیم چه چیزی و چه کسی واقعی است؟

اگر خوششانس باشیم، فناوریهای جدید فقط باعث سردرگمی مختصری میشوند. وگرنه، حوزه سیاسی ما میتواند برای همیشه تغییر کند.

نویسنده: کیتلین هارینگتون مترجم: مرجان بختیاری ۳ مرداد ۱۴۰۳

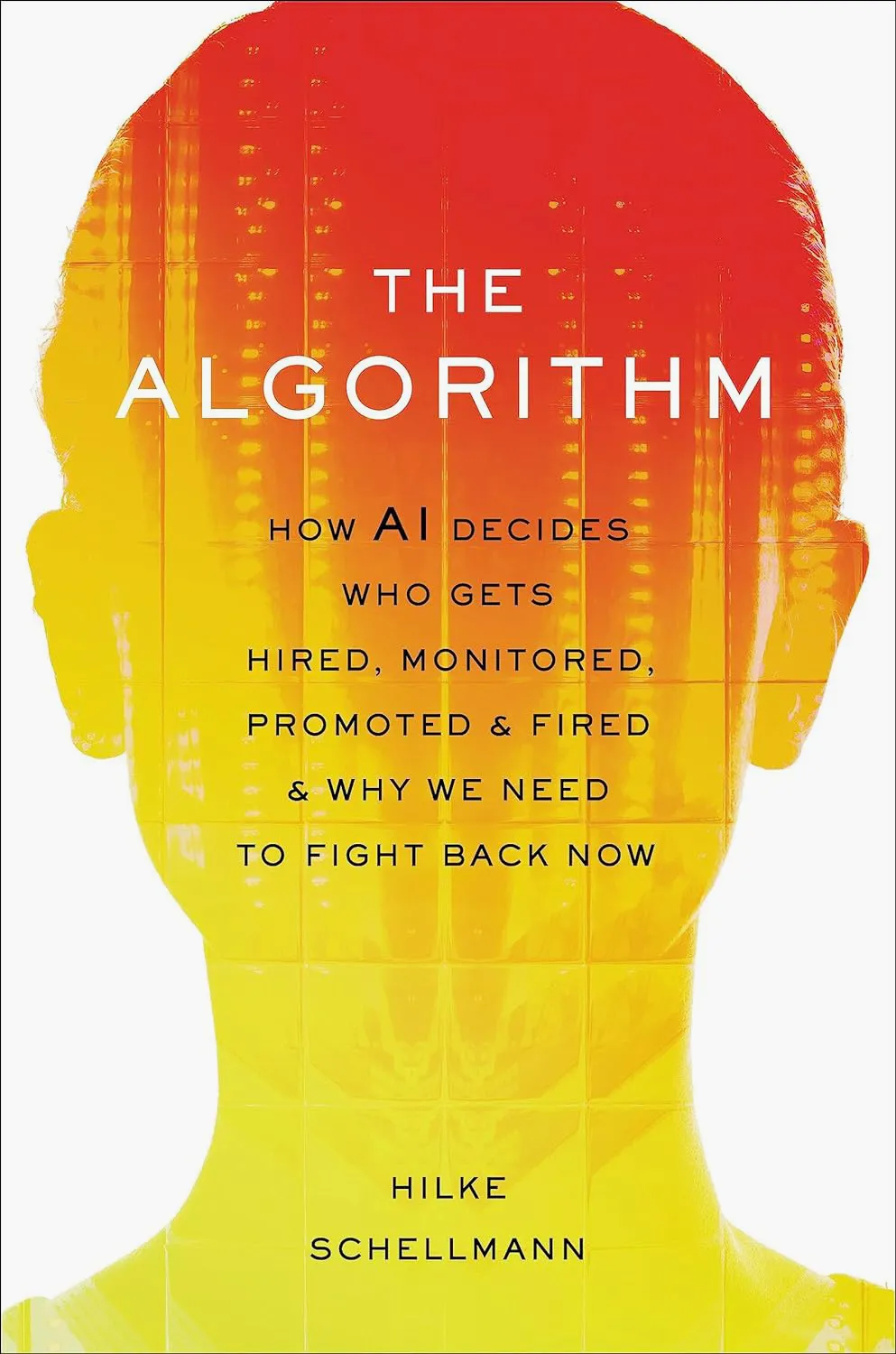

چه میشد اگر هوش مصنوعی مسئول استخدام باشد؟!

هوش مصنوعی شاید شغل شما را تصاحب نکند اما میتواند جلوی استخدام شما را بگیرد. کتاب «الگوریتم» اثر هیلکه شلمن پرده از راز رباتهایی برمیدارد که بخش منابع انسانی استفاده میکنند. نرمافزارهایی که نه تنها تبعیض را گسترش میدهند، بلکه در پیدا کردن بهترین فرد برای شغل نیز شکست میخورند.

این مطلب نوشتهای است از کیتلین هارینگتون که در تاریخ ۲ ژانویه ۲۰۲۴ با عنوان

AI May Not Steal Your Job, but It Could Stop You Getting Hired

در وبسایت WIRED منتشر شده است. ترجمه این مطلب توسط مرجان بختیاری انجام شده و در اختیار خوانندگان گرامی قرار میگیرد.

هیلکه شلمن روزنامهنگار، در کتاب جدید خود با عنوان «الگوریتم»، نرمافزاری را بررسی میکند که غربالگری رزومه و توصیههای ارتقای شغلی را به صورت خودکار انجام میدهد و نگرانیهایی را در مورد تبعیض ایجاد میکند.

اگر نگران هستید که الگوریتمهای غربالگری رزومه، بین شما و شغل رویاییتان مانعی ایجاد کنند، خواندن کتاب «الگوریتم» اثر هیلکه شلمن خیالتان را راحت نمیکند. کتاب جدید این خبرنگار پژوهشی و استاد روزنامهنگاری دانشگاه نیویورک، پرده از راز نرمافزارهای اتوماتیکی که بخش منابع انسانی استفاده میکند برمیدارد؛ نرمافزارهایی که نه تنها تبعیض را گسترش میدهند، بلکه در کاری که ادعای انجامش را دارند، یعنی پیدا کردن بهترین فرد برای شغل، شکست میخورند.

شلمن برای آزمایش برخی از این نرمافزارها، خود را به عنوان یک کارجوی احتمالی جا زد. این نرمافزارها شامل غربالگرهای رزومه، آزمونهای مبتنی بر بازیهای ویدیویی و ارزیابیهای شخصیت میشوند که حالات چهره، لحن صدا و رفتار در شبکههای اجتماعی را تحلیل میکنند. یک ابزار او را برای یک شغل کاملاً مناسب تشخیص داد، در حالی که او به زبان آلمانی چرت و پرت میگفت. الگوریتم ارزیابی شخصیت، بر اساس استفاده او از توییتر امتیاز بالایی برای «ثبات» به او داد اما بر اساس پروفایل لینکدیناش امتیاز پایینی گرفت.

این موضوع کافی است که باعث شود شما بخواهید حساب کاربری لینکدین خود را حذف کنید و به زندگی خودکفایانه روی بیاورید، اما شلمن بینشهای مثبتی نیز دارد. در یک مصاحبه که متن خلاصه شده آن در ادامه میخوانید، او پیشنهاد داد که جامعه چگونه میتواند «تکنولوژی منابع انسانی متعصب» را مهار کند و همچنین نکات عملی برای جویندگان کار ارائه داد تا بتوانند با رباتها مقابله نمایند.

کایتلین هرینگتون: شما طی سالهای گذشته در مورد استفاده از هوش مصنوعی بمنظور استخدام برای وال استریت ژورنال، مجله فناوری امآیتی، و گاردین گزارشهایی نوشتهاید. در چه مرحلهای به این فکر افتادید که این موضوع میتواند یک کتاب باشد؟

هیلکه شلمان: یکی از لحظاتی که به این فکر افتادم زمانی بود که در یکی از اولین کنفرانسهای تکنولوژی منابع انسانی در سال ۲۰۱۸ شرکت کردم و با ابزارهای هوش مصنوعی که وارد بازار میشدند روبرو شدم. حدود ۱۰هزار نفر، صدها فروشنده، تعداد زیادی خریدار و شرکتهای بزرگ حضور داشتند. متوجه شدم که این یک بازار عظیم و در حال تسلط بر منابع انسانی است.

شرکتهای نرمافزاری اغلب محصولات خود را به عنوان راهی برای حذف تعصب انسانی از فرآیند استخدام معرفی میکنند. اما البته هوش مصنوعی میتواند تعصب موجود در دادههای آموزشی خود را جذب و بازتولید کند. شما یک غربالگر رزومهای را کشف کردید که وقتی عبارت «آفریقایی-آمریکایی» را در رزومه تشخیص میداد، نمرات کاندیدا را تعدیل میکرد.

شلمن: قطعا شرکتها میگویند ابزارهایشان جانبدارانه عمل نمیکنند، اما این ابزارها چگونه تست شدهاند؟ آیا کسی خارج از شرکت این موضوع را بررسی کرده است؟ دفترچه راهنمای یک شرکت نشان میداد که هوش مصنوعی استخدام آنها با دادههای دانشجویان ۱۸ تا ۲۵ ساله آموزش داده شده است. ممکن است آنها فقط چیز خاصی را دربارهی افراد ۱۸ تا ۲۵ ساله کشف کرده باشند که برای سایر کارگرانی که این ابزار روی آنها به کار گرفته میشود، کاربردی نباشد.

آسیب یک مدیر منابع انسانی که به صورت دستی استخدام میکند محدود است، و بدیهی است که باید از آن جلوگیری کنیم. اما یک الگوریتم معیوب که برای امتیازدهی به صدها هزار کارگر استفاده میشود، میتواند به افراد بسیار بیشتری نسبت به هر فردی آسیب برساند.

حالا، بدیهی است که فروشندگان نمیخواهند مردم به درون «جعبههای سیاه» نگاه کنند. اما فکر میکنم کارفرمایان هم از بررسی اجتناب میکنند، چون به این صورت میتوانند با اظهار ناآگاهی، به طور موجه مسائل را انکار نمایند. مثلا اگر ۵۰۰هزار نفر برای یک شغل درخواست داده باشند و بخاطر مشکلات سیستم مدعی حقوقشان باشند. به همین دلیل است که نیاز به شفافیت و آزمایش بیشتر داریم.

درست است، زیرا آنها ممکن است قوانین اشتغال را نقض کنند. حتی وقتی که فروشندگان، ارزیابیهای بررسی تعصب را انجام میدهند، شما مینویسید که آن ارزیابیهای معمولاً شامل تبعیض علیه معلولیت نمیشوند. آیا در مورد اینکه چه کسی مسئولیت تبعیض اعمال شده از سوی هوش مصنوعی را عهددار است، شفافیتی وجود دارد؟

این یک سوال باز است زیرا هنوز دعاوی حقوقی در این زمینه ندیدهایم. بسیاری از وکلا میگویند شرکتی که استخدام را انجام میدهد در نهایت مسئول است، زیرا آن شرکت تصمیم استخدام را میگیرد. فروشندگان همیشه میگویند: «ما تصمیمگیری نمیکنیم. شرکتها تصمیم میگیرند. هوش مصنوعی هرگز کسی را رد نمیکند.»

این ممکن است در برخی موارد درست باشد، اما متوجه شدم که برخی از فروشندگان از محدودیتهای رد خودکار برای افرادی که زیر سطح خاصی امتیاز میگیرند استفاده میکنند. ایمیل رد و بدل شدهای بین یک فروشنده و یک ناحیه آموزشی وجود داشت که در آن قید شده بود افرادی که در ارزیابی مبتنی بر هوش مصنوعی زیر ۳۳ درصد امتیاز میگیرند، رد خواهند شد.

فکر میکنم همه کارفرمایان امیدوارند که این ابزارها موفقترین کاندیداها را پیدا کنند، اما ما اثبات زیادی برای این موضوع نداریم. ما دیدهایم که کارفرمایان در هزینه نیروی کار صرفهجویی زیادی میکنند. فکر میکنم این اغلب تنها چیزی است که آنها میخواهند.

فکر میکردم، شاید به سادگی، مردم بیشتر متوجه میشوند که هوش مصنوعی را نمیتوان کورکورانه باور کرد و اغلب به دخالت انسان نیاز دارد. اما برای بسیاری از شرکتها، پذیرش این موضوع تقریباً هدف نرمافزار منابع انسانی خودکار را که صرفهجویی در زمان است، از بین میبرد.

فروشندگان بسیاری، از شبکههای عصبی عمیق برای ساخت این نرمافزار هوش مصنوعی استفاده میکنند، بنابراین آنها اغلب دقیقاً نمیدانند که این ابزار [هوش مصنوعی] پیشبینیهای خود را بر چه اساسی انجام میدهد. اگر قاضی از آنها بپرسد که چرا کسی را رد کردهاند، بسیاری از شرکتها احتمالاً نمیتوانند پاسخ دهند. این یک مشکل در تصمیمگیریهای مهم است. ما باید بتوانیم این ابزار را راستیآزمایی کنیم.

اگر الگوریتمها را بر اساس کارمندان موفق فعلی آموزش دهید و در تصمیمگیریهای استخدامی گذشته تعصب وجود داشته باشد، به نظر میرسد که این روند یک دستورالعمل برای تداوم آن تعصب اعمال شده در گذشته است.

من از چند افشاگر شنیدهام که دقیقاً همین موضوع را کشف کردهاند. در یک مورد، یک غربالگر رزومه با رزومههای افرادی که در شرکت کار کرده بودند، آموزش داده شده بود. این ابزار الگوهای آماری را بررسی کرده و متوجه شد که افرادی که کلمات «بیسبال» و «بسکتبال» را در رزومه خود داشتند موفق بودند، بنابراین به آنها چند امتیاز اضافی داد. و افرادی که کلمه «سافتبال» را در رزومه خود داشتند، تنزل داده شدند. و البته، در ایالات متحده، افرادی که «بیسبال» را در رزومه خود دارند معمولاً مردان هستند، و کسانی که «سافتبال» را مینویسند معمولاً زنان هستند.

با وجود آشنایی با برخی از کاربردهای هوش مصنوعی در فرایند استخدام، در مورد استفاده از آن در خصوص افراد شاغل و تعیین اخراج یا ارتقا آنها، آگاهی کمتری داشتم. این موضوع چه نگرانیهایی را در شما برمیانگیزد؟

یک شرکت از دادههای کارت ورود و خروج (حضور و غیاب) استفاده کرد تا درک کند کدامیک از کارمندان پربازدهتر هستند. بدیهی است که این یک معیار ناقص است زیرا تعداد ساعاتی که در دفتر میگذرانید نشان نمیدهد چقدر بهرهور هستید. اما آنها از این دادهها برای ارتقا استفاده کردند، و زمانی که شرکت در دوران همهگیری مجبور به انجام اخراجها شد، به این دادهها نگاه کردند تا تعیین کنند که چه کسی کمتر موفق بوده است. بنابراین من فکر میکنم وقتی دادهها در دسترس هستند، برای شرکتها بسیار وسوسهانگیز میشود که از آنها استفاده کنند.

شما برخی از این ارزیابیهای شخصیت مبتنی بر بازی و تحلیل حالات چهره را با شبهعلمهای باستانی مانند قیافهشناسی و جمجمهشناسی مقایسه میکنید. چه چیزی باعث ایجاد این ارتباط در ذهن شما شد؟

فکر میکنم زمانی شروع شد که نتایج مطالعهای منتشر شد که براساس گرایشات جنسی بود و که سعی میکرد با استفاده از الگوریتم و عکسهای یک اپلیکیشن دوستیابی، ماهیت ظاهری افراد همجنسگرا یا دگرجنسگرا را کشف کند. هنوز هم این باور عمیق وجود دارد که سیگنالهای بیرونی، حالات چهره، نحوهی حرکت بدن، و آهنگ صدا، جوهرهی وجودی ما را حمل میکنند. ما این را در گذشته با تحلیل حالات چهره در قرن نوزدهم دیدهایم که ادعا میکرد مجرمین چهرههای متفاوتی نسبت به غیرمجرمین دارند، یا تحلیل خط. هیچ علم واقعی پشت این موضوع نبود، اما جذابیت آن وجود داشت. حالا ما تکنولوژی اندازهگیری حالات چهره و سایر سیگنالهای بیرونی را داریم، اما مشکل این است که برخی از شرکتها این موارد را «معنادار» نشان میدهند، در حالی که واقعاً معنایی وجود ندارد.

یک کامپیوتر میتواند یک لبخند را مقدارسنجی کند، اما نمیداند که آیا در پشت آن لبخند من خوشحالم یا نه. بنابراین جوهره واقعی خود را نشان نمیدهد. ما این را در ابزارهای تحلیل رسانههای اجتماعی با استفاده از هوش مصنوعی میبینیم؛ این ایده که میگوید «اگر به توییتر شما نگاه کنم، شخصیت واقعی شما را پیدا خواهم کرد.»

تصمیمات مربوط به آینده شغلی افراد گاه به گونهای گرفته میشود که گویی سرنوشت آنها دستخوش تصادف و خارج از کنترلشان است. یک شخص چه کاری میتواند انجام دهد تا کمی اختیار به دست آورد؟

هوش مصنوعی تولیدکننده در واقع مقداری از قدرت را به متقاضیان شغل بازگردانده است. من در رسانههای اجتماعی افراد زیادی را دیدهام که دربارهی چگونگی استفاده از چت جی بی تی برای ساختن رزومهی بهتر و نوشتن نامههای درخواست صحبت میکردند. برخی از متقاضیان از آن برای تمرین پاسخ دادن به سوالات مصاحبه استفاده میکنند. این به معنی هوش مصنوعی در برابر هوش مصنوعی است.

ابزارهای آنلاین رزومه وجود دارند که میتوانید شرح شغل و رزومهی خود را در آنها آپلود کنید، و کامپیوتر میزان همپوشانی بین آنها را محاسبه میکند. مطمئناً نمیخواهید که از ۱۰۰ درصد کلیدواژهها مربوط به شغلتان استفاده کنید، زیرا در این حالت رزومهی شما احتمالاً به عنوان کپی تشریح شغل علامتگذاری میشود؛ بهتر است در محدوده ۶۰ تا ۸۰ درصد باشید.

«شما باید برجسته باشید» یک شعار قدیمی بود اما دیگر کاربردی ندارد، زیرا به احتمال زیاد رزومهی شما توسط هوش مصنوعی غربالگری میشود که بیشتر از آنچه اکثر مردم فکر میکنند مستعد خطا است. بنابراین یک ستون با بخشهای برچسبگذاریشده و واضح مانند «تجربهی کاری» و «مهارتها» داشته باشید تا کامپیوتر بتواند آنها را بخواند.

نکتهی دیگری که ممکن است به شما برای دیده شدن کمک کند، تماس با افراد استخدامکننده در لینکدین بعد از ارسال درخواست است. همچنین در صحبت با بسیاری از افراد استخدامکننده متوجه شدم که شاید بخواهید درخواست خود را مستقیماً از طریق وبسایت شرکت ارسال کنید، زیرا این اولین جایی است که آنها نگاه میکنند. سپس آنها به پلتفرمهای کاریابی مانند لینکدین یا Indeed میروند.

اینها نکات خوبی هستند. دوباره احساس قدرت میکنم.

و من فکر میکنم تغییر ممکن است. فکر میکنم یک سازمان غیرانتفاعی لازم است که شروع به آزمایش ابزارهای استخدام هوش مصنوعی کند و نتایج را به صورت عمومی در دسترس قرار دهد. من در واقع مقداری بودجه اولیه برای این کار به دست آوردم. فکر میکنم بسیاری از دانشگاهها متوجه شدهاند که فناوری و جامعه به سرعت در حال تغییر هستند و ما باید افرادی که روی مشکلات اجتماعی کار میکنند و افرادی که روی مشکلات فنی کار میکنند را گرد هم بیاوریم. اما من همچنین فکر میکنم روزنامهنگاران میتوانند چیز خاصی به ارمغان بیاورند، زیرا ما همیشه در جریان هستیم. ما میتوانیم از روزنامهنگاری دادهمحور (data journalism) برای کمک به یافتن پاسخهای معتبر به این سؤالات بزرگتر استفاده کنیم.

فکر میکنید دولت چه نقشی در تنظیم مقررات این ابزارها باید داشته باشد؟

برخی از کارشناسان میگویند ما باید یک آژانس صدور مجوز دولتی داشته باشیم که ابزارهای پیشبینی را زمانی که برای تصمیمگیریهای مهم استفاده میشوند، آزمایش کند. مطمئن نیستم که دولتها توانایی انجام این کار را داشته باشند، زیرا کار بسیار عظیمی است. امیدوارم دولت شفافیت بیشتری را اعمال کند و دسترسی به دادهها را باز کند. این امر به پژوهشگران، دانشمندان و روزنامهنگاران امکان میدهد تا خودمان وارد عمل شویم و آزمایش را انجام دهیم. این گام بزرگی در جهت درست خواهد بود.

درباره نویسنده:

کیتلین هارینگتون؛ نویسنده در سایت وایرد است که سابقه همکاری با مجله سانفرانسیسکو را دارد.