جدیدترین مطالب

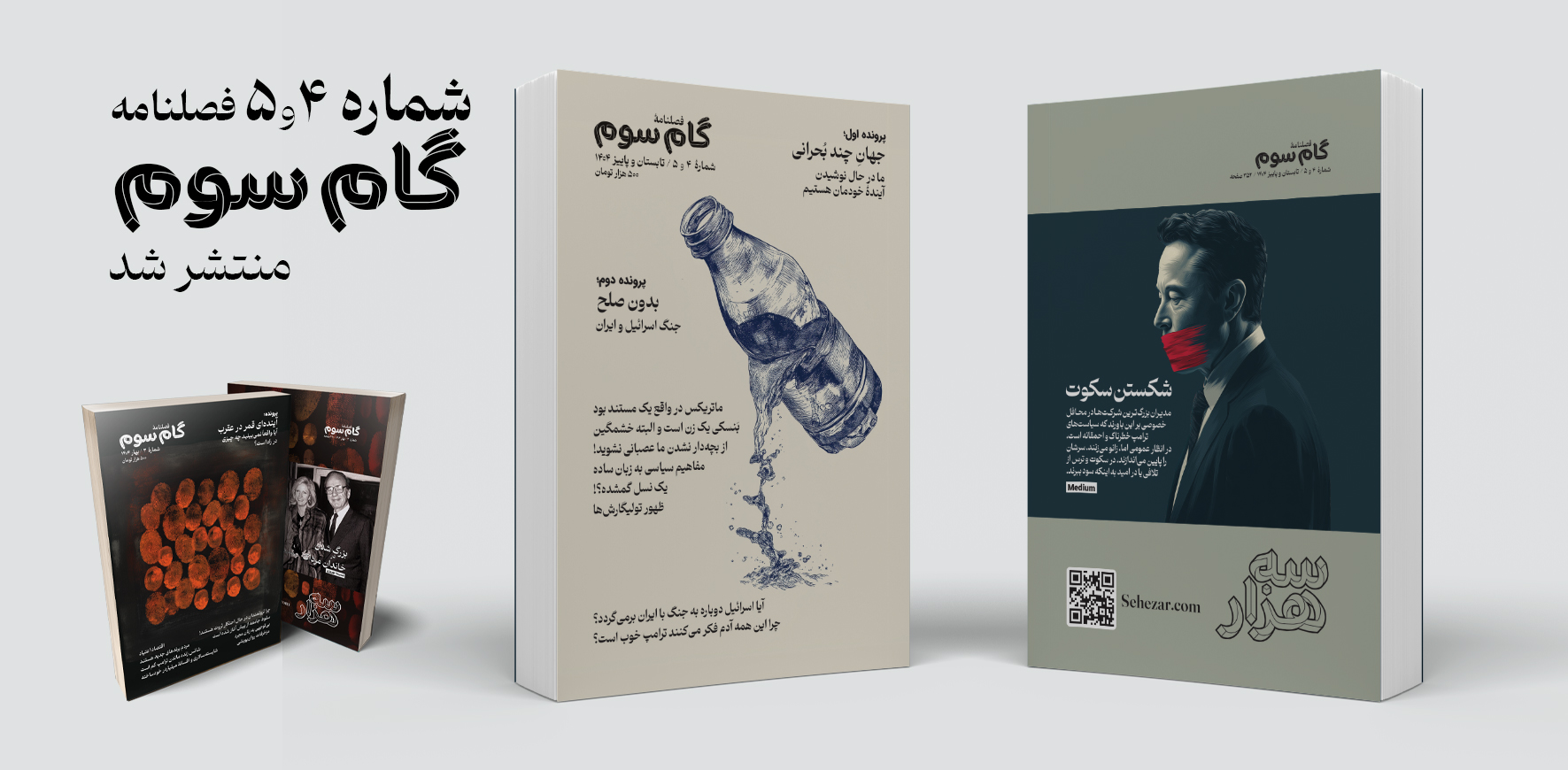

فصلنامه «گام سوم» شماره ۴ و ۵

در این نوبت از فصلنامه گام سوم دو شماره «۴ تابستان» و «۵ پاییز» بهطور همزمان منتشر شده است که همچون شمارههای پیشین شامل مقالات متنوعی در موضوعات اقتصاد، آینده مشاغل، خانواده، نوشتار و سیاست به همراه دو پرونده با موضوعات داغ روز میشود.

۱۳ رفتار غیرمعمول مدیران موفق که شاید شما را شگفتزده کند!

ادارهی یک شرکت کاری پر استرس است، بهویژه اگر یکی از بزرگترین شرکتهای جهان را مدیریت کنید. این میزان بالای استرس میتواند به عادتهای روزانهی شدید و غیرمعمول منجر شود. در ادامه، برخی از عجیبترین روالهای روزانهی مدیرعاملها آمده است.

چرا نترسیدن شرط یافتن پاسخهای مهم است؟

فهمیدم سلامت روانم بهتر شده است، وقتی به خارج از کشور رفتم و دیگر دچار شوک فرهنگی نشدم.من بخش زیادی از خودم را در دخترانم میبینم. آنها مشتاقاند وظایفشان را درست انجام دهند و اگر احساس کنند چیزی ممکن است «نامناسب» به نظر برسد، ناراحت و آشفته میشوند.

داستان های علمی تخیلی؛ پلی میان تخیل و ارتباط علمی مؤثر

وقتی وارد دوره دکترایم شدم، میدانستم به همان اندازه که از انجام پژوهش لذت میبرم، عاشق انتقال علم به عموم مردم نیز هستم. اما خیلی زود پژوهش بیشتر وقت مرا بلعید. اغلب تا نیمههای شب کار میکردم و بیشتر آخر هفتههایم صرف آمادهسازی آزمایشها، گردآوری دادهها یا جبران عقبماندگی از انبوه پایانناپذیر مقالات علمی روی میزم میشد.

پربازدیدترین مطالب

جهان خسته از نابرابری و ثروتمندان

با تشدید بحرانهای محیطزیستی، اجتماعی و انسانی، جهان دیگر قادر به تحمل دو چیز نیست: ۱- هزینههای نابرابری اقتصادی ۲- جامعه ثروتمندان. کاهش نابرابری اقتصادی بهتنهایی درمانی برای این بحرانهای جهانی نیست، اما نقش محوری در حل همه آنها دارد.

روند ۱۰۰ ساله تغییر اشتغال زنان به روایت تصویر

نگاهی به تصاویر صد سال گذشته نشان میدهد که زنان چگونه از جنگهای جهانی تا قرن ۲۱، توانستند مرزهای شغلی را جابهجا کنند و مسیر جدیدی در تاریخ نیروی کار رقم بزنند.

هوش مصنوعی و سیاست: چگونه بفهمیم چه چیزی و چه کسی واقعی است؟

اگر خوششانس باشیم، فناوریهای جدید فقط باعث سردرگمی مختصری میشوند. وگرنه، حوزه سیاسی ما میتواند برای همیشه تغییر کند.

نویسنده: بیلی پریگو و ویل هنشال مترجم: نیوشا امیدی ۱۲ مرداد ۱۴۰۴

هشدار کارمندان سابقOpenAI : «میزان مخاطره بسیار بالاست»

هر دوی آنها معتقدند که توانمندی سامانههای هوش مصنوعی در سالهای پیشرو بهطرز چشمگیری افزایش خواهد یافت و این تحولات پیامدهایی بنیادین برای جامعه در پی خواهند داشت. کوکوتایلو میگوید: «میزان مخاطره واقعاً بسیار بالاست.»

این مطلب نوشتهای است از بیلی پریگو و ویل هنشال که در تاریخ ۵ ژوئن ۲۰۲۴ با عنوان

The Stakes Are Incredibly High

در وبسایت New York Times منتشر شده است.

این مصاحبه ممکن است برای ویلیام ساندرز هزینهبر باشد. او که پیشتر بهعنوان پژوهشگر ایمنی در OpenAI فعالیت میکرد، در فوریه از این شرکت استعفا داد و مانند بسیاری دیگر از کارکنان جداشده،توافقنامهای مبنی بر عدم بدگویی امضا کرد تا بتواند حق فروش سهام خود در شرکت را حفظ کند. با اینکه وی میگوید OpenAI از آن زمان به او اعلام کرده که قصدی برای اجرای مفاد این توافقنامه ندارد و در این خصوص تعهدات عمومی مشابهی نیز ارائه داده است، اما همچنان با بیان اظهاراتش ریسک میکند. او به نشریه تایم میگوید: «ممکن است با گفتوگو با شما هرگز نتوانم به سهامی که ارزش آن میلیونها دلار است، دسترسی پیدا کنم. اما بهنظر من، داشتن یک گفتوگوی عمومی درباره آنچه در این شرکتهای AGI رخ میدهد مهمتر است.»

افراد دیگری نیز چنین احساسی دارند. روز سهشنبه، سیزده نفر از کارکنان فعلی و پیشین شرکتهای OpenAI و گوگل دیپمایند خواستار حمایتهای قویتر از افشاگران در شرکتهایی شدند که در حال توسعه هوش مصنوعی پیشرفته هستند. این درخواستها در شرایطی مطرح شد که نگرانیها نسبت به احتمال خروج کنترل این فناوری قدرتمند از دست بشر افزایش یافته است. آنها در نامهای سرگشاده، از این آزمایشگاهها خواستند تا به کارکنان «حق هشدار» بدهند،بهطوریکه بتوانند در صورت بروز نگرانیهای ایمنی، به نهادهای ناظر، اعضای هیئتمدیره و افکار عمومی هشدار دهند.

این نامه پس از مجموعهای از استعفاهای پرسروصدا در OpenAI منتشر شد؛ از جمله ایلیا سوتسکِوِر، دانشمند ارشد شرکت، که در نوامبر سال گذشته به برکناری سم آلتمن رأی داد اما در نهایت از شرکت کنار گذاشته شد. سوتسکِوِر تاکنون بهصورت عمومی درباره این رویدادها اظهار نظر نکرده و دلایل استعفای او نامشخص است. پژوهشگر ارشد دیگری در حوزه ایمنی، یان لایکه، نیز در ماه مه استعفا داد و اعلام کرد که فرهنگ ایمنی در OpenAI در اولویت پایینتری نسبت به عرضه محصولات جدید قرار گرفته است.

او تنها فردی نیست که بهتازگی از شرکت جدا شده است. دنیل کوکوتایلو، یکی از کارکنان پیشین و از امضاکنندگان نامه سرگشاده، در ماه آوریل استعفا داد و در فضای آنلاین نوشت که دیگر اطمینان ندارد این آزمایشگاه در صورت ساخت AGI (هوش عمومی مصنوعی)،فناوریای نظری که تمامی آزمایشگاههای پیشروی هوش مصنوعی در تلاش برای ساخت آن هستند و میتواند وظایف اقتصادی با ارزش را بهتر از انسان انجام دهد،رفتار مسئولانهای از خود نشان دهد. پس از استعفا، کوکوتایلو از امضای توافقنامه عدم بدگویی که شرکت از کارکنان جداشده درخواست میکند، امتناع ورزید. او باور داشت که با این اقدام، میلیونها دلار از سهام خود در OpenAI را از دست میدهد. پس از آنکه وبسایت Vox گزارشی درباره مفاد این توافقنامه منتشر کرد، OpenAI سیاست خود را تغییر داد و اعلام کرد که از کارکنانی که از شرکت انتقاد کردهاند، سهامی پس نمیگیرد.

OpenAI در بیانیهای تأکید کرد که گفتوگوی عمومی درباره هوش مصنوعی پیشرفته امری ضروری است. لیندسی هِلد، سخنگوی OpenAI، به نیویورک تایمز گفت: «ما به سابقه خود در ارائه ایمنترین و توانمندترین سامانههای هوش مصنوعی افتخار میکنیم و به رویکرد علمی خود برای مدیریت ریسک باور داریم. ما با این دیدگاه موافقیم که بحث و بررسی دقیق در این حوزه، با توجه به اهمیت این فناوری، حیاتی است و به تعامل با دولتها، نهادهای جامعه مدنی و سایر جوامع در سراسر جهان ادامه خواهیم داد.»OpenAI از اظهار نظر بیشتر به تایم درباره ادعاهای مطرحشده در این گزارش خودداری کرد؛ گوگل دیپمایند نیز درباره این نامه سرگشاده موضعگیری عمومی نداشته و به درخواست تایم برای اظهارنظر پاسخ نداده است.

اما در گفتوگو با نشریه تایم، دو کارمند سابق OpenAI،دنیل کوکوتایلو، که در تیم حاکمیت شرکتی فعالیت میکرد، و ویلیام ساندرز، پژوهشگر تیم «همراستاسازی فوقپیشرفته»،اظهار داشتند که حتی فراتر از توافقنامههای عدم بدگویی، قراردادهای محرمانگی با تعاریف گسترده که در آزمایشگاههای پیشروی هوش مصنوعی رایجاند، افشای عمومی نگرانیها را برای کارکنان بسیار پرریسک میکند. هر دوی آنها معتقدند که توانمندی سامانههای هوش مصنوعی در سالهای پیشرو بهطرز چشمگیری افزایش خواهد یافت و این تحولات پیامدهایی بنیادین برای جامعه در پی خواهند داشت. کوکوتایلو میگوید: «میزان مخاطره واقعاً بسیار بالاست.»

در صنایعی که تحت نظارت دولت قرار دارند، مانند امور مالی، افشاگران از حمایت قانونی دولت ایالات متحده برخوردارند و در صورت افشای تخلف، حتی میتوانند سهمی از جریمههای موفق را دریافت کنند. اما از آنجا که در زمینه توسعه هوش مصنوعی پیشرفته هیچ قانون مشخصی وجود ندارد، افشاگران در این صنعت از چنین حمایتهایی بیبهرهاند و حتی ممکن است بهدلیل نقض قراردادهای عدم افشا یا عدم بدگویی، خود در معرض پیگرد قانونی قرار گیرند. کوکوتایلو میگوید: «حمایتهای قانونی پیشین از افشاگران در اینجا کاربردی ندارد، چون این صنعت در عمل تحت نظارت نیست، و بنابراین قانونی برای بسیاری از کارهای بالقوه خطرناکی که ممکن است شرکتها انجام دهند، وجود ندارد.»

ساندرز میگوید: «آزمایشگاههای AGI واقعاً در برابر هیچکس پاسخگو نیستند. پاسخگویی مستلزم آن است که اگر سازمانی کار اشتباهی انجام دهد، اطلاعات مربوط به آن قابل اشتراکگذاری باشد. و در حال حاضر چنین چیزی وجود ندارد.»

ساندرز میگوید زمانی که در سال ۲۰۲۱ به OpenAI پیوست، امیدوار بود که شرکت درگیر مجموعهای از پرسشهای دشوار باشد: «اگر ماشینی وجود داشته باشد که بتواند همان کاری را که شما انجام میدهید،و برای جامعه اقتصادی ارزش دارد،انجام دهد، واقعاً چقدر قدرت در یک جامعه دارید؟ آیا میتوانیم جامعهای دموکراتیک داشته باشیم وقتی جایگزینی برای نیروی کار انسانی وجود دارد؟» اما پس از انتشار ChatGPT در نوامبر ۲۰۲۲، OpenAI بهتدریج به شرکتی کاملاً متفاوت تبدیل شد. ارزش آن به دهها میلیارد دلار رسید و مدیران آن در رقابتی نفسگیر برای پیشیگرفتن از رقبا قرار گرفتند. ساندرز میگوید اکنون بهنظر میرسد پرسشهایی که او امیدوار بود OpenAI به آنها بپردازد، «به تعویق افتادهاند و اولویت خود را در برابر عرضه محصول بعدی و پرزرقوبرقتر از دست دادهاند.»

در نامه سرگشاده، ساندرز، کوکوتایلو و شماری دیگر از کارکنان فعلی و پیشین خواستار آن شدند که آزمایشگاههای هوش مصنوعی از وادار کردن کارکنان به امضای توافقنامههای عدم بدگویی دست بکشند؛ فرایندی برای مطرح کردن نگرانیها نزد اعضای هیئتمدیره، نهادهای نظارتی و گروههای دیدهبان ایجاد کنند؛ و «فرهنگ انتقاد آزادانه» را تقویت نمایند. در این نامه آمده است که اگر افشاگر، پس از تلاش برای بیان نگرانیها از طریق این مسیرها، تصمیم به انتشار عمومی آنها بگیرد، شرکتهای هوش مصنوعی باید متعهد شوند که هیچگونه تلافی یا اقدام تنبیهی علیه او انجام نخواهند داد.

حداقل یک کارمند فعلی OpenAI نامه سرگشاده را در شبکههای اجتماعی مورد انتقاد قرار داده و استدلال کرده است که عمومیکردن نگرانیهای ایمنی توسط کارکنان، رسیدگی به مسائل بسیار حساس را برای آزمایشگاهها دشوارتر میکند. جاشوا آچیم، دانشمند پژوهشی در OpenAI، در پستی در ایکس (پلتفرمی که پیشتر با نام توییتر شناخته میشد) نوشت: «اگر میخواهید ایمنی در OpenAI بهدرستی عمل کند، یک پایهی اولیه از اعتماد باید وجود داشته باشد؛ جایی که همهی افرادی که با ما کار میکنند بدانند که ما محرمانگیشان را حفظ خواهیم کرد. این نامه، ترک بزرگی در آن پایه ایجاد کرده است.»

با این حال، این نوع استدلال تا حدی بر پایهی رفتار مسئولانهی رهبران OpenAI استوار است،رفتاری که رویدادهای اخیر آن را زیر سؤال بردهاند. ساندرز معتقد است که سم آلتمن، مدیرعامل شرکت، ذاتاً در برابر پاسخگویی مقاومت میکند. او میگوید: «من فکر میکنم بهویژه دربارهی سم آلتمن، او با نظارت و پاسخگویی بسیار ناخوشایند است. نشانهاش هم این است که هر گروهی که ممکن است نقشی نظارتی بر او داشته باشد،از جمله هیئتمدیره و کمیته ایمنی و امنیت،آلتمن احساس میکند باید شخصاً در آن حضور داشته باشد، و هیچکس نمیتواند به او «نه» بگوید.»

پس از آنکه آلتمن در نوامبر گذشته توسط هیئتمدیره پیشین OpenAI برکنار شد، شرکت حقوقی WilmerHale تحقیقی درباره شرایط این برکناری انجام داد و به این نتیجه رسید که «رفتار او دلیلی برای عزل وی فراهم نکرده است.» هیئتمدیره جدید OpenAI بعداً «اعتماد کامل» خود را به رهبری آلتمن ابراز کرد و در ماه مارس، کرسی هیئتمدیرهی او را بازگرداند. لری سامرز و برت تیلور، دو عضو جدید هیئتمدیره، اخیراً در اکونومیست نوشتند: «ما آقای آلتمن را در همه مسائل مرتبط بسیار صریح و در تعامل با تیم مدیریتی خود همواره خوشرفتار یافتهایم.»

برای ساندرز، پاسخگویی امری حیاتی است،و بدون وجود نهادهای ناظر بیرونی و مستقل، نمیتوان آن را محقق ساخت. او میگوید: «اگر بخواهیم یک توسعهدهندهی AGI واقعاً در خدمت منافع عمومی باشد و به آرمان ساخت هوش عمومی مصنوعی ایمن و مفید پایبند بماند، باید سازوکارهایی برای نظارت و پاسخگویی وجود داشته باشند که بهراستی شرکت را به این آرمان متعهد نگه دارند. در آن صورت، در جهانی ایدهآل، اهمیتی نداشت که چه کسی بر صندلی مدیرعامل نشسته است. این واقعاً نگرانکننده است اگر جهان ناچار باشد مدام تشخیص دهد کدام مدیرعامل در این شرکتهای هوش مصنوعی دارای شخصیت اخلاقی بهتری است. این وضعیت خوبی نیست که در آن قرار داریم.»

درباره نویسنده:

بیلی پریگو و ویل هنشال روزنامهنگارانی هستند که برای نشریات معتبری مانند واشنگتن پست و تایمز فعالیت کردهاند و بیشتر به خاطر پوشش اخبار فناوری، اطلاعات نهادهای امنیتی و رسانههای اجتماعی شناخته میشوند.